Recurrent Neural Network

Recurrent Neural Network

إيه هي RNN و إزاي بيشتغل؟

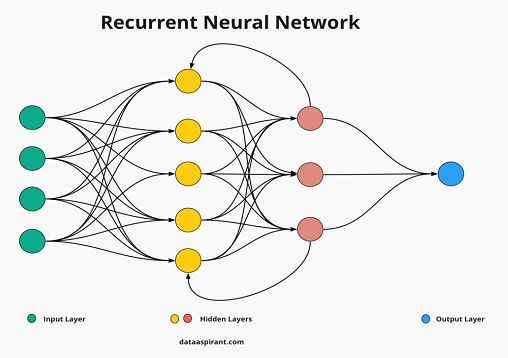

RNN (اللي هي اختصار لـ Recurrent Neural Network) هي نوع من الشبكات العصبية (Neural Networks) اللي بيتم استخدامها في التعامل مع البيانات اللي بتكون متسلسلة أو ليها علاقة ببعضها عبر الزمن. الـ RNN ده بيعتبر أداة أساسية في مجالات كتير زي تحليل النصوص، التنبؤ بالوقت، والتعرف على الصوت. الفكرة من الـ RNN إنه بيتعامل مع المدخلات في كل خطوة زمنية وبيحاول يتذكر المعلومات اللي بتيجي من الخطوات اللي فاتت علشان يقدر يستخدمها بشكل صحيح في التنبؤ أو اتخاذ القرارات.

الفرق بين RNN و ال Traditional Neural Network :

الـ RNN بيشتغل بشكل مختلف عن الشبكات العصبية التقليدية (زي MLP)، اللي بتتعامل مع المدخلات في خطوة واحدة فقط. ال Traditional Neural Networkما بتقدرش تتابع السياق الزمني للبيانات، لكن الـ RNN قادر على الاحتفاظ بالمعلومات من الماضي (Hidden State) علشان يستخدمها في المستقبل. في الـ RNN، بترتبط كل خطوة زمنية بالخطوات اللي قبلها، وده بيخليها مثالية للمشاكل اللي بتحتاج تتعامل مع Sequence data.

مكونات الـ RNN

⦁ Input (المدخلات): دي البيانات اللي بتدخل على الmodel في كل خطوة زمنية.

⦁ Hidden State (الحالة المخفية): دي المعلومات اللي ال model بيحفظها علشان يستخدمها في ال prediction أو اتخاذ القرارات في المستقبل.

⦁ Output (المخرجات): دي النتيجة اللي بيطلعها ال model في كل خطوة زمنية.

إزاي الـ RNN بيشتغل؟

الـ RNN يعمل على معالجة المدخلات عبر الزمن (خطوة تلو الأخرى) باستخدام ال Hidden State التي يتم تحديثها بناءً على المدخلات السابقة.

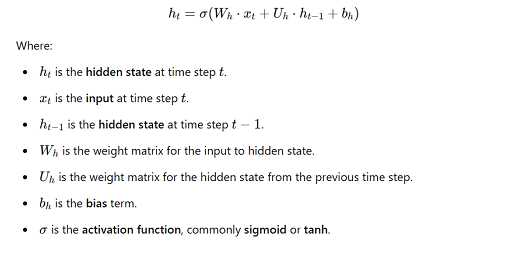

1.المعادلة الأساسية للحالة المخفية (Hidden State) :

في كل خطوة زمنية t، يتم تحديث ال hidden state بناءً على المدخلات (inputs) السابقة xtوالحالة المخفية السابقة . ht−1 المعادلة الرياضية التي تمثل هذا التحديث هي:

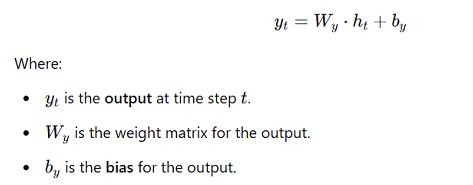

2.المعادلة الخاصة بالمخرجات (Outputs) :

بعد تحديث الhidden state بناءً على ال inputs السابقة وال hidden State السابقة، يتم حساب المخرجات بناءً على الحالة المخفية. المعادلة الخاصة بالمخرجات هي:

الانتشار العكسي عبر الزمن (Backpropagation Through Time – BPTT) :

ال BPTT هو الأسلوب الي بيُستخدم لتحديث ال weights في ال RNN .الطريقة دي بتقوم هذه بحساب ال gradient لكل weights من خلال ال Backpropagation.

1 . حساب ال gradient بالنسبة للoutputs :

أولًا، نقوم بحساب ال gradient بالنسبة للأخطاء في المخرجات ty :

حيث Loss هي الخسارة (الفقد) التي يتم حسابها بناءً على الفرق بين actual output و ال predicted output .

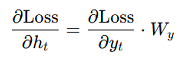

2. حساب ال gradient بالنسبة للحالة المخفية ht :

الخطوة التالية باستخدام gradients of the output هنحساب gradients بالنسبة الht . الgradient بالنسبة لل hidden state يكون:

3.حساب ال gradient بالنسبة ل weights (Wh) , (Uh) :

بناءً على الgradient الخاصة بال ht،بنحساب ال gradient بالنسبة لل weights :

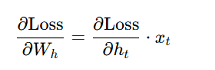

⦁ التدرج بالنسبة لـ Wh:

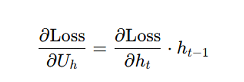

⦁ التدرج بالنسبة لـ Uh :

4.حساب ال gradient بالنسبة لل hidden State في الخطوة الزمنية السابقة ht−1:

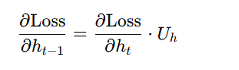

بما أن ال hidden state في الوقت t تعتمد على ال hidden state في الوقت t−1،بنحساب ال gradient بالنسبة لل hidden state في الوقت t−1 :

5. تحديث الأوزان ( (update Weightsباستخدام Gradient Descent :

بعد حساب ال gradient ل Weights وال hidden state ، بن update ال weights باستخدام Gradient Descent أو خوارزميات متقدمة زي Adam :

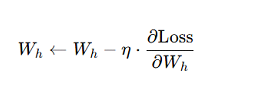

تحديث ال weight (Wh) :

تحديث ال weight (Uh) :

حيث:

⦁ η هو معدل التعلم (Learning Rate) .

التحديات في الـ RNN:

⦁ ال Vanishing Gradients : عند التعامل مع تسلسلات طويلة جدًا، ممكن ال gradient يكون صغير جدا اثناء ال backpropagation ، وده بيجعل من الصعب على ال model تعلم الأنماط الزمنية الطويلة.

⦁ الExploding Gradients : في بعض الأحيان، ممكن ال gradient يكون كبير جدا وده بيؤدي إلى تحديثات ضخمة لل weights ويصعب ال training .

حلول لمشاكل الـ RNN:

⦁ LSTM (Long Short-Term Memory): تم تطوير LSTM للتغلب على مشكلة Vanishing Gradients عن طريق استخدام البوابات (Gates) للتحكم في تدفق المعلومات.

⦁ GRU (Gated Recurrent Units): هو نوع آخر من الـ RNN يحل أيضًا مشاكل Vanishing Gradients باستخدام بوابات مشابهة لـ LSTM .

إمتى تستخدم RNN؟

الـ RNN مفيد جدًا في الحالات اللي بتحتاج تتعامل فيها مع بيانات متسلسلة أو ليها علاقة زمنية. مثلاً:

⦁ الترجمة الآلية: لو بتترجم جمل بين لغتين، وخصوصًا لما الجمل طويلة أو السياق معقد.

⦁ التعرف على الصوت: في تطبيقات زي التعرف على الكلام أو فهم الكلام في الوقت الحقيقي.

⦁ التنبؤ بالوقت: لو عندك بيانات بتتغير مع الوقت زي درجات الحرارة أو حركة الأسهم، الـ RNN بيقدر يتنبأ بالبيانات المستقبلية بناءً على المعلومات السابقة.

إمتى مفيش داعي تستخدم RNN؟

⦁ البيانات مش متسلسلة: لو البيانات مش متسلسلة أو مفيهاش علاقة زمنية، زي الصور أو البيانات الثابتة.

⦁ البيانات قليلة: لو عندك كمية قليلة من البيانات، الـ RNN مش هيبقى الخيار الأفضل علشان ممكن يواجه مشاكل زي الـ Overfitting .

⦁ بيانات بتتغير بسرعة: لو التتابع بين البيانات مش مهم أو التغيرات سريعة جدًا.

أنواع الـ RNN

⦁ Vanilla RNN: ده النوع التقليدي من الـ RNN، بيتم استخدامه في معالجة تسلسل واحد من البيانات.

⦁ Bidirectional RNN: ده النوع اللي بيشتغل في اتجاهين، يعني بيقرأ البيانات من الأول للآخر والعكس.

⦁ LSTM (Long Short-Term Memory): ده نوع متطور من الـ RNN مصمم علشان يحل مشكلة الـ Vanishing Gradient ويحتفظ بالمعلومات لفترات أطول.

⦁ GRU (Gated Recurrent Units): ده نوع تاني من الـ RNN يشبه الـ LSTM، لكنه أبسط في تصميمه وأسرع في التدريب.

الخلاصة:

الـ RNN هو model قوي ومرن جدًا في الذكاء الاصطناعي، وهو مثالي لمعالجة البيانات اللي فيها تتابع زمني أو علاقات بين المدخلات على مر الزمن. لكن لو عايز تستخدمه، لازم تكون فاهم إمتى بيكون مناسب، وإمتى مفيش داعي لاستخدامه. لو عرفت تختار بينه وبين ال models التانية، هتقدر تحقّق نتائج مميزة في مشروعك.