Llama 3.3

Llama 3.3

مقدمة عن Llama 3.3

Meta أعلنت عن ال modelالجديد Llama 3.3، اللي يعتبر واحد من أقوى ال models في مجال الـ Transformers. الmodel ده بيجمع بين الدقة العالية والكفاءة، وده بيخليه مناسب لحاجات كتير زي تحليل النصوص، الإجابة على الأسئلة، الترجمة، وإنشاء المحتوى. مش بس كده، ال model بيتميز إنه بيعتمد على 70 مليار parameter بس، ومع ذلك بيحقق أداء شبه مثالي مقارنة بالmodels الأكبر زي Llama 3.1 405B.

Meta ما اكتفتش بالكفاءة بس، لكنها كمان ركزت على تكلفة التشغيل اللي أقل بشكل ملحوظ، وده بيخليه مثالي للشركات الناشئة والأفراد اللي شغالين بموازنات محدودة.

أهم المميزات في Llama 3.3

1. تعدد اللغات

واحدة من أقوى مميزات Llama 3.3 هي دعمه لـ 8 لغات أساسية زي الإنجليزي، الفرنسي، الإسباني، والهندي. ده بيجعله أداة ممتازة للفرق اللي بتشتغل على مستوى عالمي وبتحتاج تنجز المهام بلغات متعددة.

2.تعامل مع نصوص طويلة جدًا

الميزة دي بتفتح الباب لاستخدامه في تحليل مستندات قانونية أو طبية، كتابة تقارير ضخمة، أو حتى التعامل مع المشاريع اللي محتاجة معلومات مترابطة على مدى طويل.

3. دعم الأدوات الخارجية

الميزة دي بتسمح لل model يتكامل مع أنظمة أكتر تعقيدًا زي الـ APIs أو Function Calling. ده بيجعله مثالي لتطبيقات زي chatbots اللي ممكن تستدعي وظائف أو خدمات مباشرة بناءً على طلب المستخدم.

4. كفاءة التكلفة

Meta نجحت في جعل Llama 3.3 أقل تكلفة بكتير مقارنة ب models تانية بنفس الحجم. تكلفة ال tokens اللي بتدخل هي $0.1 لكل مليون، واللي بتخرج بـ $0.4 لكل مليون، وده مناسب جدًا لمشاريع الذكاء الاصطناعي اللي بتحتاج استدامة مالية.

5. أداء متفوق

الأداء بتاع ال model على الـ benchmarks زي MMLU وTruthfulQA بيأكد إنه مش بس model عادي، لكنه قادر ينافس models الأكبر منه زي GPT-4.

مقارنة Llama 3.3 بال models السابقة

- الكفاءة والحجم:

- اLlama 3.3 بيشتغل بـ 70 مليار براميتر بس، مقارنة بـ Llama 3.1 اللي كان بـ 405 مليار. النتيجة؟ نفس الأداء تقريبًا، لكن بسرعة أعلى وكفاءة أكبر.

- التكامل مع الأدوات:

- ال model الجديد دعم حاجات زي الـ Function Calling، واللي مكانتش متوفرة بالشكل ده في Llama 3.1.

- دعم اللغات:

- Llama 3.3 بيتميز بتوسع دعم اللغات مقارنة بالإصدارات السابقة، وده بيخليه مناسب جدًا للاستخدام العالمي.

- التكلفة:

- الكفاءة اللي في استهلاك الموارد مع تقليل التكلفة التشغيلية بتميز Llama 3.3 عن غيره.

استخدام Llama 3.3 عمليًا

دلوقتي تعال نتكلم عن إزاي نبدأ مع ال model ده خطوة بخطوة على Hugging Face .

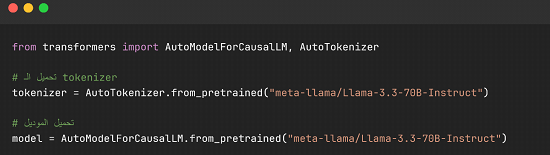

تحميل ال model

أول حاجة، تأكد إن مكتبة transformers مثبتة عندك:

بعد كده حمل ال model :

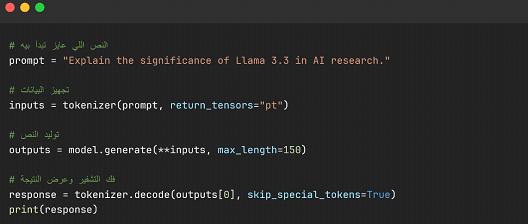

استخدام ال model لكتابة النصوص

ملاحظات على الكود:

⦁ max_length: تأكد إن القيمة دي مناسبة لحجم النص اللي محتاجه.

⦁ skip_special_tokens: دي بتشيل الرموز الخاصة من النص الناتج عشان يطلع أنظف.

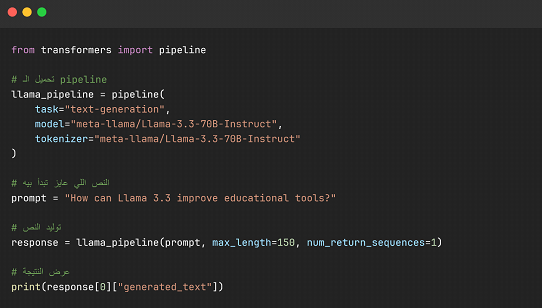

تبسيط الاستخدام بالـ pipeline

لو مش عايز تدخل في تفاصيل كتير، استخدم الـ pipeline اللي بتوفره مكتبة Transformers :

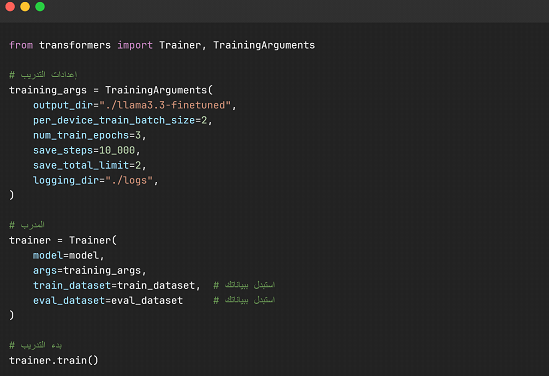

نصائح لتخصيص Llama 3.3 (Fine Tuning)

لو عايز تضيف لمستك على ال model أو تدربه على بيانات مخصصة، استخدم الكود التالي:

تطبيقات عملية لل model

1.تطوير الـ Chatbots

Llama 3.3 ممتاز لإنشاء chatbots ذكية بتفهم سياق المحادثة.

2.الكتابة الإبداعية

لو شغال على كتابة قصص أو سيناريوهات، ال model ده هيبقى مساعد قوي.

3.الترجمة

ال model بيدعم ترجمة متعددة اللغات بجودة عالية.

4.البحث العلمي

Llama 3.3 بيقدر يقرأ أبحاث طويلة، يلخصها، ويرد على أسئلة بناءً عليها.

الخلاصة

Llama 3.3 مش بس model جديد، لكنه بداية لثورة في مجال الذكاء الاصطناعي. كفاءته، دعمه للتطبيقات المتنوعة، وتكلفته المنخفضة بيخلوا أي حد يقدر يستفيد منه، سواء شركات كبيرة أو حتى فرق صغيرة.

جرب ال model بنفسك على Hugging Face، وشوف إزاي هيغير طريقتك في التعامل مع الـ AI .